Die im Dunkeln sieht man doch

Langsam ist die Gesichtserkennung im Alltag angekommen. Facebook hat sein seit Jahren existierendes entsprechendes Feature auch für europäische Nutzer freigeschaltet. Das derzeit neueste iPhone wird nicht mehr durch Fingerabdruck entsperrt, sondern per Blick aufs Display. Bei den olympischen Spielen 2020 in Tokio soll ein entsprechendes System benutzt werden, um Athleten, Presseleute und Mitarbeiter zu identifizieren, die bestimmte Bereiche betreten dürfen. Das Medienunternehmen Live Nation, zu dem auch der Dienstleister Ticketmaster gehört, kaufte das auf Gesichtserkennung spezialisierte Unternehmen Blink Identity, um Konzertbesucher künftig beim Einlass anhand ihres Gesichts zu kontrollieren, statt mit Hilfe eines vorgezeigten Tickets.

Begehrlichkeiten weckt diese Technologie schon lange auch bei Ermittlungsbehörden zahlreicher Länder. So benutzte die US-Polizei nach dem Amoklauf in der Redaktion der Capital Gazette in Annapolis, Maryland, im Juni Gesichtserkennungssoftware, um den Todesschützen zu identifizieren. Das FBI soll Fotos von 117 Millionen US-Amerikanern gespeichert haben.

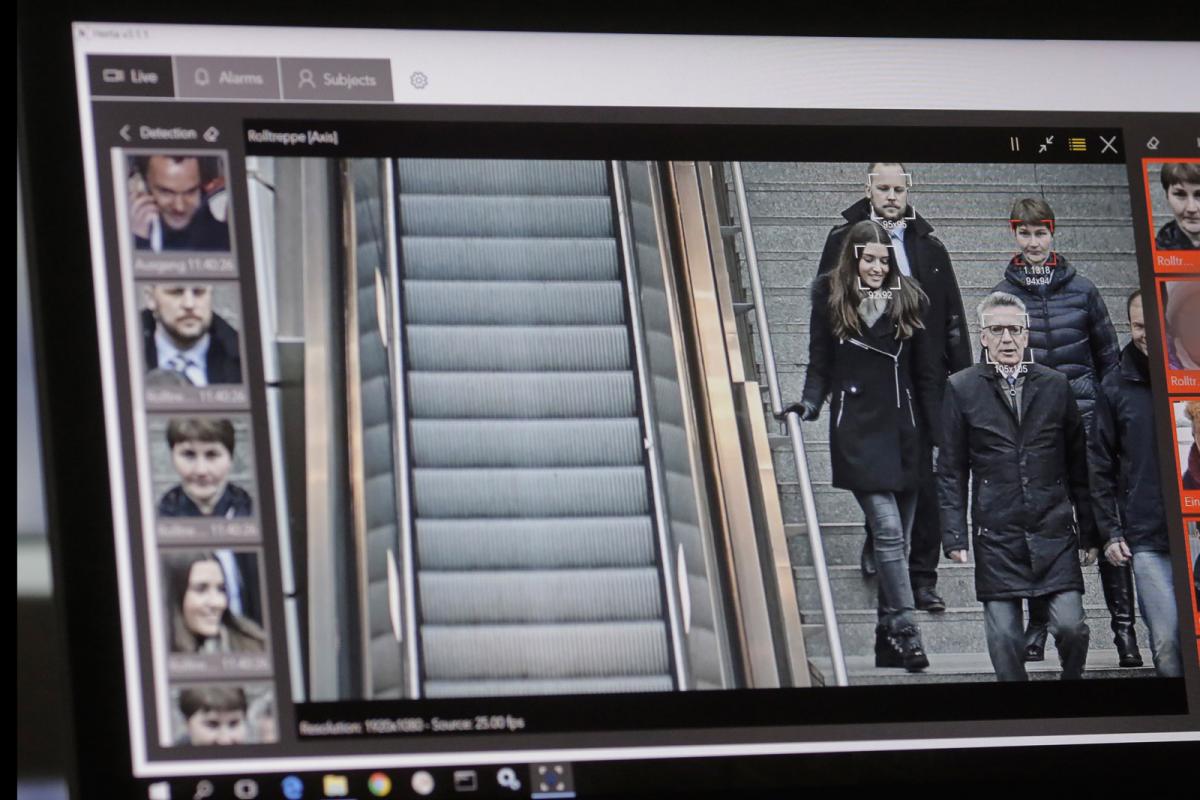

In China verwenden Polizisten Datenbrillen, um gesuchte Personen zu erkennen und aus der Menge zu fischen. Auch in Deutschland wird automatische Gesichtserkennung eingesetzt: Die Hamburger Polizei benutzte sie, um nach dem G20-Gipfel mögliche Straftäter auf vorliegendem Bild- und Videomaterial zu identifizieren. Am Berliner Bahnhof Südkreuz wurde monatelang ein System zur Gesichtserkennung getestet. Das Argument für die Totalüberwachung lautet meistens: Attentäter wie Anis Amri sollen sich nicht mehr unerkannt in der Öffentlichkeit bewegen können.

Zur Gesichtserkennung soll die Verhaltenskontrolle hinzukommen. Daran wird 2009-2014 im EU-Forschungsprojekt Indect gearbeitet.

Da scheint der Aufruf von Brad Smith, Präsident und oberster Jurist von Microsoft, zum richtigen Zeitpunkt zu kommen. Mitte Juli wandte er sich auf dem offiziellen Microsoft-Blog an die Öffentlichkeit, IT-Unternehmen und den US-Kongress und forderte gesetzliche Regelungen für die Gesichtserkennung. Unternehmen, die solche Software entwickeln oder nutzen, hätten eine besondere Verantwortung, dies nur im ethisch vertretbaren Rahmen zu tun, schrieb Smith, der sich technische Mindeststandards wünscht. Nur Systeme, die mindestens eine bestimmte, noch festzusetzende Erkennungsrate leisten, sollten zugelassen werden. Außerdem müsse sichergestellt werden, dass diese Technologie nicht zum Zwecke von racial profiling eingesetzt werde. Explizit erwähnt Smith die US-Behörde United States Immigration und Custom Enforcement (ICE), die unter anderem dafür zuständig ist, illegale Einwanderer zu überwachen und auszuweisen. Als die ICE im Juni kritisiert wurde, weil sie Eltern und Kinder illegaler Einwanderer voneinander getrennt hatte, traf das auch Microsoft, weil der Konzern die ICE mit Software beliefert – allerdings nur mit Standard-Software für den Büroeinsatz, wie Smith betonte.

Bereits die ausführliche Erwähnung der ICE zeigt, dass es in Smiths Brandbrief nicht alleine um die Sorge wegen der gesellschaftlichen Folgen automatischer Gesichtserkennung geht, sondern auch um Marketing. Seine Botschaft lautete: Es gibt gute und böse Einsatzzwecke und bei den bösen mache Microsoft nicht mit. Er transportiert damit eine Botschaft an potentielle Kunden: Gesichtserkennung funktioniert und bei uns könnt ihr sie guten Gewissens kaufen.

Dabei ist fraglich, wie gut sie denn tatsächlich funktioniert. Gearbeitet wird an dieser Technik bereits seit über 30 Jahren. Die ersten lauffähigen Systeme wurden Anfang der neunziger Jahre vorgestellt. Sie taugten allerdings nur als Prototypen zur weiteren Forschung, weil ihre Erkennungsraten miserabel waren. Den Durchbruch brachte die sogenannte künstliche Intelligenz, ein missverständlicher Begriff, der Laien suggeriert, der Computer könne wie ein Mensch denken. Tatsächlich handelt es sich um komplexe Algorithmen, die teilweise menschliche Hirnstrukturen simulieren und nach längerem Training in der Lage sind, Muster in Bildern zu erkennen – wie eben Gesichter. Dabei kommt das System nie zu eindeutigen Ergebnissen, sondern erreicht einen Wahrscheinlichkeitswert. Problematisch am Einsatz solcher Systeme ist, dass abgewägt werden muss, ab welchem Wahrscheinlichkeitswert sie Alarm schlagen sollen. Eine Person auf einem Foto ist mit einer Wahrscheinlichkeit von drei, 50 oder 97 Prozent mit einer gesuchten Person identisch: Wird der Schwellenwert zu niedrig gesetzt, verwechselt das System zu viele Personen miteinander. Wird der Wert zu streng gesetzt, gehen dem System zu viele gesuchte Personen durch die Lappen.

Was mit dieser Technologie praktikabel ist, hängt vom Einsatzzweck ab. Es macht einen großen Unterschied, ob per Gesichtserkennung ein Telefon entsperrt werden soll oder ob im öffentlichen Raum massenhaft Menschen überwacht werden.

Streiken auf der Plattform

Streiken auf der Plattform